Protección de Datos avisa que desnudar a otras personas con IA ya puede ser delito o acarrear multas con las leyes actuales

El regulador recuerda que la imagen de una persona se considera un dato personal y su manipulación y difusión sin consentimiento puede violar la normativa de privacidad

Los 10 días de porno machista con IA que pueden costar caro a Elon Musk: “No es cuestión de bikini o burka, sino de consentimiento”

El Gobierno quiere incluir la generación de imágenes o vídeos falsos de otras personas con inteligencia artificial en el catálogo de delitos contra el honor. Estos contenidos, conocidos como deepfakes, están suscitando una considerable alarma social y protestas de las personas afectadas. Según los datos que maneja Naciones Unidas, “hasta el 95% de los deepfakes son imágenes pornográficas no consentidas, y el 99% de las víctimas son mujeres”. El Consejo de Ministros aprobará este martes en primera vuelta el anteproyecto de ley con el que pretende poner coto a esta actividad.

La Agencia Española de Protección de Datos (AEPD) ha enviado un aviso este martes: manipular la imagen de otras personas con IA, especialmente si implica “desnudez añadida” o “contenido íntimo sintético”, ya puede acarrear multas por violar las leyes de privacidad o incluso delitos recogidos en el Código Penal.

Así lo ha expresado en un documento que detalla los riesgos “visibles e invisibles” de los deepfakes. La Agencia recuerda que cualquier imagen, vídeo o audio que permita identificar a una persona, ya sea por su rostro, voz, tatuajes o entorno, constituye un dato personal. Por tanto, su tratamiento mediante IA está sujeto a la normativa de protección de datos con independencia del realismo del resultado.

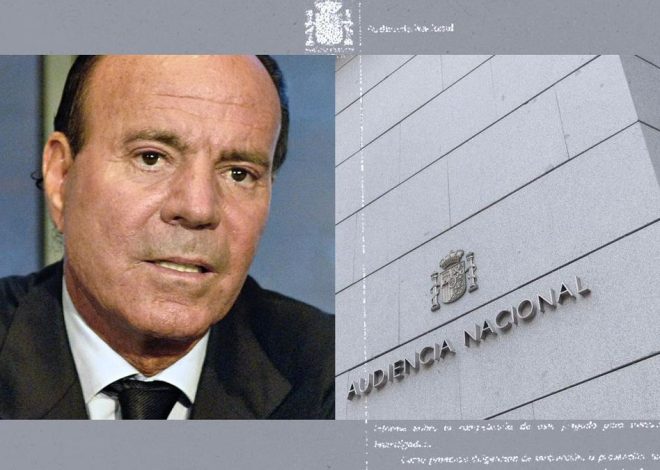

El regulador de la privacidad, de hecho, ya ha dictado resoluciones sancionatorias por este tipo de actividades. Fue en noviembre cuando la Agencia impuso la primera sanción en este sentido. En aquel caso, la resolución condenó a los padres de un menor que había creado imágenes de sus compañeras de instituto desnudas con IA a pagar 2.000 euros por violación de su privacidad. Se trataba de una sanción derivada del escándalo de Almendralejo, en el que se compartieron fotografías falsificadas de niñas menores de edad en grupos de mensajería, y que salió a la luz en septiembre de 2023.

Con todo, esta actividad ha vuelto a disparar la indignación en estos primeros días de 2026 debido a la inteligencia artificial de Elon Musk. El magnate permitió que Grok, como se llama su modelo generativo, creara este tipo de contenidos falsificados (en este caso, mostrando a las mujeres en bikini o lencería) y los publicara en abierto en X, su red social. Múltiples países europeos y la propia UE ya investigan lo sucedido. “Es ilegal, espantoso y repugnante”, declaró un portavoz comunitario.

Sexualización y humillación

En su guía de riesgos, la AEPD advierte de que el daño para la víctima de un deepfake “puede ser equivalente y en algunos casos mayor que en el caso de una imagen o un vídeo real”. Especialmente, cuando se producen situaciones de sexualización, humillación o la atribución de hechos falsos que resultan socialmente creíbles.

Además de lo que otros pueden ver al difundirse el contenido, el regulador de privacidad pone el foco en los peligros ocultos para la privacidad de los deepfakes, como “la pérdida efectiva de control” sobre su propia imagen, que puede distribuirse fácilmente en redes donde los usuarios no conocen el contexto de si es real o no. Además, una vez que la imagen se sube a una de estas plataformas, se crea un archivo que se guardará en sus bases de datos y unos metadatos (información sobre esas imágenes, como autor, fecha, formato, ubicación, etc.) que podrían llevar a la identificación de la persona que aparece en el deepfake.

“Es cierto que muchas plataformas de IA generativa incorporan mecanismos técnicos para limitar la generación de contenidos claramente lesivos”, reconoce la AEPD. “Estas medidas hacen que muchos contenidos notoriamente dañinos no lleguen a generarse, pero no garantizan que desaparezcan todos los riesgos”, añade en la guía. Fuentes del organismo aseguran que este lleva semanas trabajando en el documento y que sus recomendaciones van más allá de lo sucedido con la IA de Elon Musk en X.

Ante esta realidad, la AEPD recomienda extremar la prudencia y recalca que el uso irreflexivo de estas herramientas para “usos considerados banales o lúdicos” (como filtros o animaciones) puede dejar de considerarse una actividad “estrictamente doméstica” si el contenido se difunde de forma masiva o impacta gravemente en la vida profesional o personal del afectado, lo que puede acarrear sanciones. En los casos más graves, pueden existir “indicios de delito” que hagan que el organismo derive el caso ante autoridades policiales y judiciales.

Finalmente, la Agencia subraya que el uso de esta tecnología es especialmente peligroso cuando se trata la imagen de menores de edad o personas vulnerables. En los supuestos en los que se produzca una pérdida de control o un daño reputacional intenso, el organismo insta a los afectados a presentar una reclamación ante la Agencia, que cuenta con herramientas como el Canal Prioritario, una vía de urgencia que permite la retirada de determinados contenidos sexuales, violentos o vejatorios en 24 horas.